Введение в тему Директор по безопасности — ваш аналитический центр экспертов по безопасности Как стать начальником службы безопасности

-

CSO:2025年中国网络安全从合规到AI驱动风险治理趋势

一、报告摘要 核心观点 2025年中国网络安全领域正经历范式转变。监管强化与生成式AI爆发式采纳的”双重压力”,正将企业安全焦点从被动合规防御转向主动数据治…

-

Data Security Intelligence: управляемая искусственным интеллектом парадигма для защиты безопасности корпоративных данных нового поколения

В связи с быстрым развитием технологии Large Language Model (LLM) и углублением цифровой трансформации предприятий традиционная пассивная система защиты безопасности данных больше не может отвечать требованиям современных угроз. Первый в Китае интеллектуальный орган безопасности данных, основанный на генеративном искусственном интеллекте, механизме адаптивной защиты, совместной работе нескольких интеллектуальных органов и других передовых технологиях, позволит добиться смены парадигмы от "искусственного укладывания" к "интеллектуальному и активному".

-

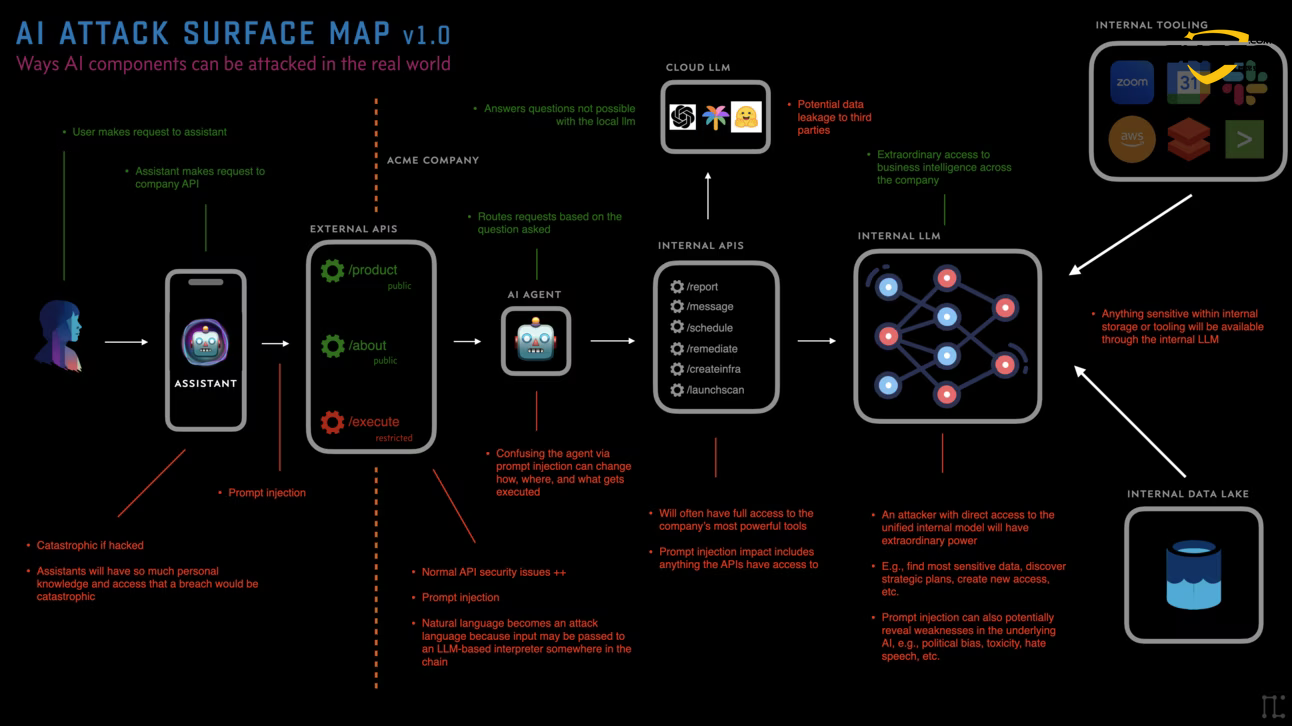

AI Security:Отчет об анализе поверхности атаки искусственного интеллекта на 2026 год

В 2026 году ландшафт безопасности ИИ претерпит фундаментальную перестройку. В ответ на глобальную нехватку кадров в области кибербезопасности, которая составляет до 4,8 миллиона человек, организации массово внедряют интеллектуальные системы ИИ с высокими привилегиями, работающие круглосуточно и без выходных, и становятся мишенью для злоумышленников. Однако эти автономные системы также быстро становятся объектом внимания злоумышленников. По прогнозам ведущих организаций по безопасности, таких как Palo Alto Networks, Moody's и CrowdStrike, к 2026 году интеллектуальные системы искусственного интеллекта станут самой большой внутренней угрозой, с которой столкнутся предприятия. Традиционные системы защиты дают сбой, поэтому возникла необходимость в новых системах управления и архитектурах защиты.

-

Глобальный ландшафт кибератак и угроз безопасности искусственного интеллекта - отчет за 2025 год

2025 год - это год "беспрецедентной сложности" в сфере кибербезопасности. С быстрым развитием и масштабным применением технологий искусственного интеллекта киберугрозы приобретают беспрецедентную сложность и масштаб. В этом отчете представлен глубокий анализ новых глобальных кибератак, типичных инцидентов безопасности, угроз безопасности ИИ и соответствующих стратегий управления рисками в 2025 году, что дает технические рекомендации и основу для принятия решений инженерам по ИИ, инженерам по безопасности и главным специалистам по безопасности (CSO).

-

Безопасность ИИ: создание системы безопасности корпоративного ИИ на основе методологии ATT&CK

В данной статье в качестве основы взята матрица угроз безопасности ИИ, и на основе зрелой методологии ATT&CK систематически рассматриваются угрозы безопасности, с которыми сталкиваются системы ИИ на протяжении всего жизненного цикла, включая отравление данных, извлечение моделей, утечку конфиденциальной информации, вражеские образцы и ключевые методы атаки, такие как внедрение слов-ключей, а также предлагаются соответствующие стратегии защиты и решения для посадки предприятий, чтобы обеспечить инженеров ИИ, инженеров безопасности и CSO профессиональными техническими средствами. Ссылка.

-

Безопасность ИИ IDE: анализ атак на антигравитационную цепочку поставок Cursor Windsurf Google

IDE для разработки ИИ, такие как Cursor, Windsurf и Google Antigravity, подвержены риску атак на цепочки поставок из-за дефектов конфигурационных файлов, унаследованных от VSCode. Эти три платформы, насчитывающие более миллиона пользователей, имеют автоматизированный механизм рекомендаций для расширений, который может быть использован злоумышленником для распространения вредоносного кода среди разработчиков путем заражения рынка расширений OpenVSX. Уязвимость позволяет злоумышленнику зарегистрировать незаявленные пространства имен расширений и загрузить вредоносные расширения, чтобы получить ключи SSH, учетные данные AWS и доступ к исходному коду без традиционной социальной инженерии. Поверхность воздействия риска подчеркивает новый вектор атаки в инструментарии разработчиков и знаменует собой официальное включение расширений IDE в рамки MITRE ATT&CK.

-

Безопасность больших моделей: введение и анализ открытого фреймворка Guardrails security fence

OpenGuardrails - это первая полная платформа безопасности с открытым исходным кодом корпоративного уровня, поддерживающая 119 языков, унифицированную архитектуру LLM, настраиваемые политики чувствительности и развертывание в нескольких облаках. В этом отчете представлен глубокий анализ основных технических инноваций, сценариев применения, моделей развертывания, сравнительного анализа производительности и будущего развития, а также рекомендации по обеспечению соответствия требованиям безопасности для приложений искусственного интеллекта в регулируемых отраслях, таких как финансы, здравоохранение и юриспруденция. Анализируя настраиваемые политики OpenGuardrails, эффективную модель и инфраструктуру производственного уровня, авторы раскрывают направление развития следующего поколения ИИ-систем безопасности.

-

CSO:Искусственный интеллект (ИИ) Кибератаки и защита Статистика, тенденции, затраты и отчет о безопасности обороны 2025 года

Искусственный интеллект (ИИ) меняет парадигму защиты и нападения в сфере безопасности. Злоумышленники используют ИИ для масштабной генерации реалистичных фишинговых сообщений, клонирования голосов руководителей, обнаружения незащищенной инфраструктуры ИИ и автоматизации проникновения. Защитники, в свою очередь, используют ИИ для более быстрого обнаружения аномалий, классификации предупреждений о рисках и локализации инцидентов. Однако нехватка навыков и неправильно настроенные архитектуры ИИ открывают двери для новых атак. В этом руководстве собрана последняя статистика кибератак с использованием ИИ за 2025 год, данные переведены в влияние на бизнес и предложен приоритетный курс действий, который вы можете реализовать уже в этом году.

-

CSO: Руководство для директора по безопасности по полной защите данных искусственного интеллекта

Руководители служб безопасности (CSO) столкнулись с беспрецедентной проблемой: системы искусственного интеллекта как усиливают существующие риски, связанные с данными, так и создают совершенно новые угрозы, такие как отравление данных, реинжиниринг моделей и заражение цепочки поставок. Данное руководство опирается на NIST AI Risk Management Framework (AI RMF), Google Secure AI Framework (SAIF) и отраслевые практики, чтобы предоставить CSO действенную систему управления безопасностью данных.

-

MCP Governance Framework: как построить модель безопасности нового поколения, противостоящую сверхспособностям ИИ

Сосредоточьтесь на том, как MCP может напрямую повлиять на существующую систему безопасности, предоставив ИИ фактическую "власть исполнения". С одной стороны, MCP позволяет ИИ получать доступ к инструментам, базам данных и бизнес-системам по единому протоколу, превращая их в мультиагентов, способных работать с разными системами, а не в пассивных ботов, задающих вопросы и отвечающих на них. С другой стороны, эта возможность опирается на "гибридную идентичность" и авторизацию и аутентификацию по длинным связям, так что четкая идентичность, минимальные привилегии и постоянная проверка, требуемые для нулевого доверия, систематически ослабляются, а скрытые угрозы, такие как отравление контекста, отравление инструментов, атаки на цепочки поставок и т. д., резко возрастают.

В настоящее время управление должно быть перестроено на основе MCP - со шлюзом в качестве концентратора, единой идентификацией, тонкой авторизацией и полным аудитом связей - для того, чтобы раскрыть истинную ценность агентского ИИ без ущерба для безопасности.